2018 и 2019 годы выдались весьма продуктивными в плане развития систем охлаждения ЦОД и понижения PUE — коэффициента использования электроэнергии. В рамках данной статьи собраны основные решения и достижения, появившиеся за последнее время.

Коэффициент использования электроэнергии PUE (Power Usage Efficiency) рассчитывается как отношение полной мощности ЦОД к мощности ИТ‑оборудования. В идеальном дата‑центре, в котором не тратится энергия на поддержание работоспособности ИТ‑оборудования, коэффициент PUE будет равен 1. На практике это недостижимо, и PUE реальных ЦОД с чиллерной системой охлаждения достигает 1,5, с фреоновой системой — 1,3–1,4. Фрикулинг позволяет снизить PUE, как мы увидим далее, вплоть до 1,03.

Снижение PUE за счет искусственного интеллекта

Потенциал применения технологий искусственного интеллекта в отрасли ЦОД в целом и в области систем кондиционирования и свободного охлаждения в частности поистине велик. Дело в том, что энергопотребление и, как следствие, эффективность систем охлаждения в значительной степени зависят от внутренних и внешних условий. Эти условия постоянно меняются, а непрерывно адаптировать под них систему в ручном режиме не представляется возможным. Обычно выбирается некий осредненный вариант, когда, как говорится, все работает, и слава богу.

Тем временем концепция Big Data (дословно «большие данные», то есть накопление обширной статистики и ее анализ) и искусственный интеллект набирают обороты. Построенные на их основе алгоритмы сначала накапливают информацию, а потом вносят корректировки в работу оборудования, опираясь на проделанный анализ. Постоянная мгновенная подстройка каждого из элементов системы кондиционирования позволяет в буквальном смысле творить чудеса.

Плавучие ЦОД

По данным компании Google, одного из лидеров в сфере внедрения технологий искусственного интеллекта в различные отрасли информационных технологий и промышленности, среднегодовое снижение энергопотребления систем охлаждения ее собственных ЦОД за счет данных технологий достигает 35%. Более полное исследование гласит, что в зависимости от региона строительства ЦОД, внутренних и наружных параметров воздуха и вида системы охлаждения экономия энергии составит от 25 до 40%. Статистике Google можно доверять, но трудно проверить — свои алгоритмы компания не раскрывает и коммерческие услуги в этой нише не оказывает. В свою очередь, компании Siemens, Huawei, AdeptDC, Carbon Relay и другие разработали коммерческие решения по оптимизации систем охлаждения в ЦОД.

Энергоэффективные ЦОД

Программные модули Optimize и Predict от компании Carbon Relay, например, сначала собирают массив данных, а потом производят на его основе сотни корректирующих воздействий. Модуль Optimize создает компьютерную модель дата‑центра, анализирует статистику изменения показателей и вырабатывает оптимальную модель управления. Модуль Predict занимается расчетами с прицелом на перспективу: накапливает дополнительный холод до наступления жары, планирует переключение между различными режимами работы холодильного оборудования и других инженерных систем ЦОД. Алгоритм практически всех подобных систем идентичен: они собирают многочисленные данные о работе центра обработки данных и вырабатывают рекомендации. Данные рекомендации направлены на снижение энергопотребления, обнаружение и устранение горячих точек, отключение лишнего оборудования.

Ошибки проектирования СКВ ЦОД

На последнем пункте — отключении лишнего оборудования — следует остановиться подробнее. Дело в том, что резервирование оборудования в ЦОД, направленное на повышение отказоустойчивости объекта, нередко оказывается избыточным. Это происходит по нескольким причинам: сказываются боязнь проектировщиков недозаложить оборудование и не обеспечить нужный уровень надежности, медленное заполнение ЦОД и другие факторы. В итоге фактический резерв оборудования существенно превышает требуемый, а PUE повышается. Технологии искусственного интеллекта позволяют повысить энергоэффективность объекта и понизить PUE при сохранении уровня надежности.

Низкий PUE за счет природы

В последние годы все чаще приходится слышать о системах охлаждения, отводящих тепло не в окружающий воздух, а, например, в море, подземные воды или горы.

Вот уже несколько лет работает подземный ЦОД компании Green Mountain, размещенный в бывшем складе боеприпасов НАТО. Он охлаждается за счет воды близлежащего фьорда, температура которой практически весь год составляет +8°C. Среднегодовой PUE объекта равен 1,18.

Один из новых объектов — ЦОД WindCores в Германии. Он устроен внутри ветряной электростанции. Мачта ветряной турбины имеет внушительные размеры: диаметр у основания составляет 13 метров при высоте около 150 метров. Внутри нее и устроен машинный зал ЦОД. Так как мачта имеет круглую форму в сечении, то и форма машинного зала — круглая (рис. 1). 92% энергии ЦОД получает от ветра и лишь 8% берет из города — тот случай, когда можно говорить о PUE ниже единицы, если принять, что электростанция является неотъемлемой частью объекта.

Компания Ocean Energy предлагает не только охлаждать ЦОД морской водой, но и получать электроэнергию из океана. Суть решения заключается в преобразовании кинетической энергии волн в электричество. Если в воду вертикально опустить трубу, то уровень воды в трубе под воздействием волн будет постоянно изменяться. Полученное вертикальное возвратно‑поступательное движение посредством сжатого воздуха передается на турбины, где и генерируется электроэнергия.

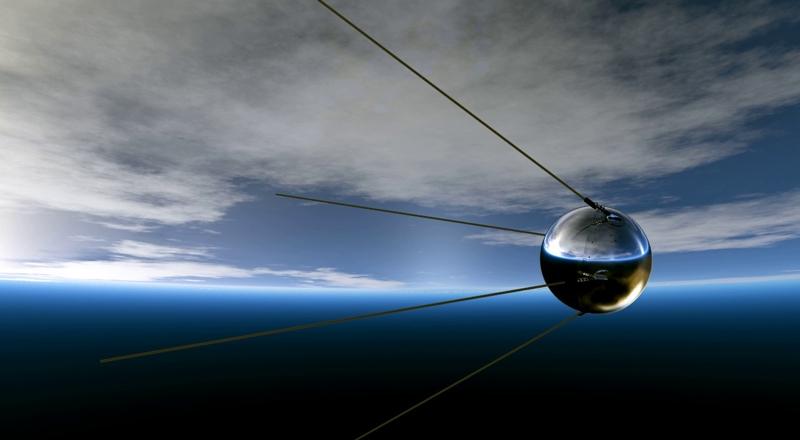

Тем временем компания Microsoft продолжает работы в рамках проекта по созданию подводного дата‑центра Project Natick. Суть его заключается в построении подводного ЦОД. На первом этапе проекта специалисты компании провели погружение и проверку работоспособности одной ИТ‑стойки. В начале июня 2018 года в Северное море на глубину 36 метров был погружен 12‑метровый контейнер с 12 стойками (рис. 2), полностью заполненными серверным оборудованием. При полной нагрузке тепловыделение ИТ‑оборудования достигает 240 киловатт и отводится за счет морской воды. Для этого в каждой стойке предусмотрены специальные теплообменники. По трубам морская вода направляется в них и охлаждает воздух, который, в свою очередь, охлаждает вычислительное оборудование. По данным компании, коэффициент PUE составил 1,07.

Системы охлаждения от Facebook и Stulz

Компания Facebook разработала собственную систему косвенного фрикулинга ЦОД SPLC (StatePoint Liquid Cooling). Новое решение отличается повышенной эффективностью как в плане использования электроэнергии, так и в плане использования воды. Схема системы представлена на рисунке 3. Высокая эффективность достигается за счет сочетания режима свободного охлаждения с испарительным и фреоновым видами охлаждения.

Концепция обычного косвенного фрикулинга с адиабатикой заключается в испарительном охлаждении наружного воздуха за счет воды и последующего охлаждения внутреннего воздуха с его помощью. Инженеры Facebook модифицировали эту схему следующим образом. В блоке SPTU (StatePoint Technology Unit) системы SPLC производится охлаждение воды за счет наружного воздуха. Далее эта вода поступает в фэнкойлы, расположенные в машинном зале ЦОД, и охлаждает внутренний воздух в помещении.

Важным отличием блока SPTU от обычного драйкулера является наличие мембранного теплообменника. Вода подается в теплообменник и увлажняет воздух, параллельно охлаждая его. Одновременно с этим охлаждается и сама вода. Если в традиционном косвенном фрикулинге для охлаждения ЦОД используется охлажденный воздух, то в системе SPLC ценность представляет охлажденная вода — именно она направляется в машинные залы ЦОД для охлаждения внутреннего воздуха. Блок SPTU фактически выполняет функцию мокрой градирни (более подробно про мокрые градирни читайте в статье «Мокрые градирни: принцип работы, сфера применения, преимущества и недостатки»

На случай жарких дней в блоке SPTU перед мембранным теплообменником предусмотрен фреоновый охладитель. В его задачу входит охлаждение наружного воздуха до такой температуры, которой будет достаточно, чтобы получить заданную температуру воды на выходе из мембранного теплообменника. Таким образом, холодопроизводительность фреонового охладителя относительно невелика: он не отводит теплоизбытки целого дата‑центра, а лишь сбрасывает «излишки» температуры в жаркие дни. Привлекательной особенностью системы охлаждения SPLC является экономия воды. По данным компании Facebook, в системе SPLC затраты воды на функционирование ЦОД на 20–90% ниже, чем в системе косвенного фрикулинга.

Классический вариант подобной схемы, когда в теплообменник подается вода для увлажнения и охлаждения воздуха и далее в системе охлаждения используется именно воздух, реализован в решении CyberHandler 2 от компании Stulz. Данные установки большую часть времени работают в режиме фрикулинга. При повышении наружной температуры в перекрестноточный рекуператор подается вода. При дальнейшем повышении наружной температуры можно использовать встроенную холодильную машину, которая удаляет излишки тепла.

Охлаждение ЦОД и отопление зданий

Повышения энергоэффективности ЦОД можно достичь не только за счет технологий свободного охлаждения и отказа от компрессионного холодильного оборудования. Еще один путь заключается в том, чтобы направить вырабатываемое в ЦОД тепло на пользу другим объектам или как минимум на пользу офисной зоне, примыкающей к дата‑центру. В самом маленьком масштабе речь идет о микро‑ЦОД, который представляет собой всего одну стойку. Мощность такой стойки может достигать 40 кВт, и этой энергии достаточно для отопления 400 квадратных метров офисных помещений.

Например, решение MicroDC от компании Stulz представляет собой серверный шкаф высотой от 40 до 48 юнитов, который охлаждается за счет циркулирующей воды, температура которой может достигать 60°C, что позволяет применять ее для отопления близлежащих помещений.

Энергоэффективное охлаждение ЦОД

Одним из ярких примеров кооперации вычислительных мощностей и отопительных приборов следует признать центр обработки компании «Яндекс» в финском городке Мянтсяля. В нем реализована технология круглогодичного прямого фрикулинга. В зимнее время года к приточному воздуху подмешивается вытяжной, чтобы не дать температуре в машинном зале ЦОД опуститься ниже требуемых значений. А на случай жары предусмотрены адиабатные увлажнители воздуха. Впрочем, в этой северной стране жара — явление весьма редкое.

Однако интерес представляет система утилизации теплоты. Вытяжной воздух нагревает воду примерно до +30°C, чего недостаточно для отопления помещений. Для повышения температуры использованы тепловые насосы. Они нагревают теплоноситель, который затем направляется в теплосеть города Мянтсяля, до 55—60°C. В дата‑центре Яндекса во Владимире также рассматриваются варианты утилизации бросового низкопотенциального тепла.

Технологии искусственного интеллекта и отопления офисной зоны сочетает в себе ЦОД Сбербанка в «Сколково». Сердцем его системы охлаждения также являются установки свободного охлаждения. С их помощью обеспечивается поддержание оптимальных параметров микроклимата в течение 330 дней в году. В жаркие дни дополнительное охлаждение воздуха выполняется за счет фреоновых доводчиков. Полученное тепло направляется на отопление прилегающей офисной зоны, а сама система свободного охлаждения тесно взаимосвязана с расположенной на объекте метеостанцией. Если прогноз погоды предвещает жаркие дни, в баках‑аккумуляторах накапливается «дешевый» холод и работа энергоемкого фреонового контура охлаждения сводится к минимуму.

Заключение

В борьбе за коэффициент использования энергии в центрах обработки данных применяются самые разные методы. Так как наибольший вклад в рост PUE вносит система охлаждения, то именно в этой области разворачивается наиболее острая битва за энергоэффективность. Среди решений стоит отметить применение прямого и косвенного фрикулинга с адиабатным увлажнением воздуха, искусственного интеллекта, отвод тепла в толщу горных пород, в море или подземные воды, а также утилизацию бросового тепла для отопления.