Основная функция центра обработки данных(ЦОД) заключается в обеспечении бесперебойной работы критически важных приложений. Тем не менее, в любой момент может произойти незапланированное отключение практически любого ЦОД.

Цифровая экономика в ее нынешнем виде далеко не совершенна. Как ни иронично, многие процессы и процедуры обслуживания инфраструктуры ЦОД, используемой для обеспечения работоспособности этой самой цифровой экономики, все еще не оцифрованы. Это выливается помимо прочего и в аварии ЦОД, которые, в свою очередь, оборачиваются серьезным репутационным и финансовым ущербом для владельцев таких серверных ферм и их корпоративных клиентов.

С каждым годом появляются все более совершенные решения для защиты ЦОД от простоев и обеспечения непрерывности бизнес-процессов. Тем не менее, текущего уровня развития технологий, судя по всему, пока еще не совсем достаточно для сведения риска ухода ЦОД в офлайн к нулю. Об этом свидетельствуют свежие новости об авариях в ЦОД Джорджтаунского университета, EUROCONTROL, Telegram и Equinix, а также известие о масштабном инциденте, охватившем сразу несколько лондонских дата-центров.

- Одна минута непредвиденного простоя центра обработки данных обходится его владельцам в десятки тысяч американских долларов. Причем этот показатель значительно увеличивается с каждым годом, о чем свидетельствуют результаты многочисленных исследований, проводимых такими организациями как Ponemon Institute и Emerson Network Power. Чтобы минимизировать вероятность даунтайма, эксперты рекомендуют владельцам и операторам ЦОД перенимать успешный опыт коллег и учиться на чужих ошибках. Помочь в этом может представленная ниже информация.

- При проектировании и строительстве современного дата-центра учитываются многие моменты и факторы: от климатических особенности до доступности квалифицированной рабочей силы. При условии надлежащего проектирования и строительства, а также дальнейшего обслуживания и обеспечения безопасности дата-центра можно добиться серьезного уменьшения риска простоя инфраструктуры и/или кражи ценных данных. Но предусмотреть все без исключения сценарии очень сложно. Поэтому аварии и взломы ЦОД все еще случаются.

Причинно-следственные факторы, подробнее:

Электроснабжение ЦОД:Аварии произошедшие в системе электроснабжения ЦОД (ИБП, ДГУ, ДИБП, АВР, Аккумуляторные батареи, ГРЩ и т.д.) | Охлаждение ЦОД:Аварии произошедшие в системе охлаждения ЦОД |

Человеческий фактор:Аварии произошедшие в датацентре по вине человека | Пожаротушение:Аварии из-за сбоев систем пожаротушения |

Подробней остановимся на громких и показательных авариях в системе охлаждения и человеческого фактора, которые произошли в последнее время, чтобы самим избежать ошибок, лучше изучить печальный опыт других.

Охлаждение ЦОД

Авария в дмитровском ЦОДе «Мегафон»: разбор полета

Под конец новогодних праздников после перепадов температуры от +2 до +10 °С москвичей ждал еще более неожиданный сюрприз: в области температура за окном понизилась до -35 °С. Такие морозы стали настоящим испытанием не только для жителей столицы, но и для дата-центров. Несмотря на то, что в Московском регионе ЦОДы должны проектироваться с учетом бесперебойной работы и при -40 °С, такие резкие температурные перепады могут негативно отразиться на работе систем охлаждения. В прошедшие праздники это и произошло с дата-центром компании «Мегафон» в Дмитрове: по утверждению абонентов, некоторые сервисы оператора связи были недоступны в течение двух дней.

С 7 января клиенты оператора начали жаловаться на перебои в работе нескольких сервисов «Мегафона», в том числе «Мегафон ТВ» и «Мультифон», также наблюдались проблемы с доступом в личные кабинеты на сайте оператора связи. Кроме того, не работали карты «Мегафон.Банка». Как заявляют в пресс-службе компании, из-за аномальных холодов в столичном регионе вышла из строя система охлаждения дата-центра.

Такое объяснение выглядит вполне логичным и даже немного успокаивающим, но подобная формулировка не объясняет главного: что же конкретно вышло из строя в системе холодоснабжения. Пресс-служба компании «Мегафон» наши запросы оставила без внимания. Однако, по одной из версий, которая активно обсуждается в социальных сетях, в связи с понижением температур до -30 °С и ниже в системе охлаждения замерз хладагент, что привело к повреждению труб и утечке этиленгликоля. Из-за длительных новогодних праздников сотрудникам дата-центра не удалось оперативно получить около 30 тонн хладоносителя, чтобы заправить систему. Служба эксплуатации организовала импровизированный фрикулинг, и в процессе была обесточена часть серверных стоек.

Во время подготовки материала мы обратились к специалистам в области холодоснабжения и попросили их высказать свое мнение касательно произошедшей аварии и того, как «разгребать» ее последствия.

Как это вообще могло произойти?

Этот вопрос напрашивается сразу же. Несмотря на то, что климат в столице относительно непостоянен, нельзя исключать одну переменную — зиму, тем более что в последние годы она длится в столице почти полгода. В связи с этим российские ЦОДы заранее проектируются с учетом аномальных температур зимой и летом (в зависимости от региона). В целом в любой точке нашей страны каждый год можно ожидать ту или иную аномалию: будь то жара и как ее следствие — смог (как в Москве в 2010 году) или -50 °С в Сибири.

Самой распространенной причиной возникновения подобного сбоя в работе оборудования является недостаточная концентрация этиленгликоля. В общей сложности температура -33 °С для Москвы — это не предел. Считается, что концентрация хладагента и количество воды в нем должны быть рассчитаны таким образом, чтобы выдержать температуру ниже -40 °С, при этом за среднюю величину обычно берут -42 °С. Кроме того, на работу системы может повлиять некачественная сварка:

- из-за плохо сваренного шва в трубах может концентрироваться вода;

- в какой-то момент ее концентрация превысит норму, и охлаждающая жидкость при замерзании буквально разорвет трубы.

К сожалению, у этой причины есть один важный фактор: экономия. Действительно, многие неоднократно сталкивались с тем, что заказчик готов пренебречь дополнительной проверкой или заложил малый бюджет на проектирование. В результате появляются мелкие просчеты, которые могут буквально вылиться вместе с этиленгликолем в немалые суммы выплат за простой дата-центра.

Андрей Перекрест, руководитель московского ЦОД Linxdatacenter: «Предположу, что причиной подобной аварии могло стать повышение концентрации воды в растворе этиленгликоля: данный теплоноситель часто применяется в системах охлаждения средних и крупных ЦОДов. Предупреждение подобных ситуаций предполагает совокупность мер, которые можно обобщенно разделить на плановую и технически грамотную эксплуатацию систем дата-центра в течение всего года, а также комплексную проверку внутренних и внешних контуров системы охлаждения в преддверии зимы. Корректный состав водных растворов гликолей не позволяет смеси замерзать при низких температурах».

Сергей Белик, независимый эксперт: «Экономия, как правило, связана не с сокращением абсолютной стоимости строительства, а с большим количеством промежуточных звеньев в цепочке реализации. До конкретных исполнителей, которые реально выполняют работы, доходит малая часть бюджета, к тому же у них не всегда есть достаточная квалификация и опыт. Особенно экономия бюджета сказывается на результатах проектирования. Системные интеграторы в дикой борьбе за заказы предлагают выполнить проектирование практически бесплатно. Да, при формировании ценового предложения в конкурсе они считают, что затраты на проектирование будут компенсированы на поставках и работах. Но на практике никто не отменял бюрократию и политику соблюдения бюджетной дисциплины. Когда дело доходит до оплаты работ по проектированию совсем другие люди, отвечающие за экономию бюджета, ищут и находят проектировщиков, которые не обязательно должны иметь нужную компетенцию — они должны выполнить работы за смешные деньги.

Далее все это накладывается на фактор невозможности «растянуть время». Проекты выполняются в сжатые сроки, проверка на непротиворечивость и согласованность работы систем часто вообще не выполняется, расчеты делаются «копипастом», проверки монтажа объекта, как правило, выполняются фрагментарно, а уж о нагрузочных проверках, да еще и в разных условиях наружных температур говорить не приходится».

Какое временное решение можно было бы внедрить для охлаждения дата-центра в такой ситуации?

Андрей Перекрест, руководитель московского ЦОД Linxdatacenter: «Если говорить об оперативном реагировании на подобные ситуации, большую роль играет компетентность команды дежурных инженеров, которые могут:

- во-первых, своевременно обнаружить проблему в функционировании систем охлаждения ЦОД;

- во-вторых, быстро принять необходимые меры по переключению на резервный контур охлаждения и (в случае обеспеченности необходимым инструментарием и материалами) приступить к ликвидации аварии».

Александра Эрлих, генеральный директор CABERO Wärmetauscher Osteuropa GmbH: «Возможно, следующий мой ответ не поймут, но это немецкая практика: в Мюнхене -30 °С тоже не редкость. Пока устраняются повреждения системы и ожидается новый хладагент, систему запускают при прямом охлаждении проточной водой. Невероятно дорого, поскольку требуется большое количество воды, просто уходящей в землю (на охлаждение ЦОДа 500 кВт требуется около 5 м3/ч.), но спасает в такой ситуации. Конечно, при условии, если есть источник воды».

Александр Овчинников, руководитель проекта ООО «АДМ Партнершип»: «С учетом того, что ЦОД — объект сложный и серьезно насыщенный инженерной инфраструктурой, очень тяжело внедрять какие-то временные решения. В общем случае требуется удалить нагретый воздух из горячих межстоячных коридоров. Думаю, это можно сделать с помощью временных вентиляторов и гибкой подводки. Но это если требуется решить проблему очень срочно, потому что необходимый объем воздуха вряд ли получится удалить — скорее всего, потребуется уменьшение потребления на каждую стойку. Каждый ЦОД индивидуален, и временные решения определяются исходя из текущей ситуации. Если работоспособность ЦОД жизненно важна, то, как правило, компании стараются использовать технологию разнесенных взаиморезервируемых ЦОДов. В случае выхода из строя системы одного ЦОДа обработка информации осуществляется на резервном дата-центре».

Что еще могло произойти с системой охлаждения?

Сергей Белик, независимый эксперт: «Непосредственных причин сбоя в работе системы охлаждения может быть множество, но реальных причин всегда две, и они не имеют отношения к технике. Во-первых, экономия бюджета при создании ЦОДа; во-вторых, святая уверенность некоторых людей, что время можно замедлить или купить.

Что может стать технической причиной сбоя в работе системы охлаждения в таких условиях, предугадать невозможно. Это может быть и «разморозка» задвижек на трубопроводах чиллерной системы, которые расположены на улице, а в системе управления кондиционированием не был реализован алгоритм постоянной циркуляции холодоносителя при низких наружных температурах. Или аварийная остановка фреоновых машин по низкому давлению в магистрали, поскольку для расчетов взяли не самые низкие возможные температуры в конкретной локации ЦОД, а средние значения для климатической зоны по СНИП. Или отсутствие подогрева на управляемых задвижках, да и просто некачественный сварной шов, который держал давление при номинальных давлениях и температуре, но при резких температурных перепадах его прочность стала ниже. Таких причин могут быть сотни…»

Евгений Колесник, директор центра поддержки клиентов Stack Group: «Возможной причиной замерзания хладагента может быть недостаточная концентрация этиленгликоля. Это вопрос выбора компании-поставщика и качества хладагента. В наших реалиях необходима концентрация, обеспечивающая работу при температурах ниже -40 °С».

Борис Грановский, директор по развитию ООО «АМД Проект»: «Обычно для небольших ЦОДов применяются фреоновые системы охлаждения, а там, как правило, конденсат отводится на улицу или в систему канализации. Если не стоит зимний комплект подогрева слива, то он (слив) мог попросту замерзнуть — бачок с конденсатом переполнился, и кондиционеры встали… Вторая типичная причина остановки фреоновых кондиционеров в мороз — это замерзание смазки в фреоне.

Для водяных систем причины могут быть аналогичные: замерзание слива и замерзание охлаждающей жидкости.

Жаловаться на погоду — значит показать свой непрофессионализм. В любом руководстве по проектированию сказано, что надо учитывать климатический фактор: для большинства регионов России значение зимней температуры — это -40 °С.

Считаю, что виноваты люди:

- – во-первых, работники, которые проектировали и строили, — в том, что не предусмотрели защиту от «дураков»;

- – во-вторых, те, кто отвечает за эксплуатацию, так как они не провели надлежащей подготовки и не работали в «боевом режиме» с наступлением холодов».

Александра Эрлих, генеральный директор CABERO Wärmetauscher Osteuropa GmbH:

«Принципиально возможны следующие причины:

- изначально неверно рассчитанная концентрация гликоля;

- с целью повышения энергоэффективности и/или получения необходимых параметров на неверно рассчитанном и подобранном оборудовании систему в теплое время года пускали на воде/слабоконцентрированном гликоле и забыли дозаправить гликолем перед морозами;

- плохо изготовленная смесь, со временем расслоившаяся на воду и гликоль;

- маловероятный, но также возможный и знакомый из практики случай: из-за разницы температур на градирне снег подтаивал, и при этом температура не была достаточно высокой, чтобы растопить его полностью. Драйкулер постепенно замерз, как замерзают испарители, и образовалось так называемое ледяное гнездо, которое и порвало аппарат. Если кто-то видел повреждения от «ледяных гнезд», понимает, о чем я говорю: аппарат выглядит так, словно внутри него взорвали мощную петарду».

Приходилось ли вам сталкиваться с подобными случаями?

Борис Грановский, директор по развитию ООО «АМД Проект»: «Ошибок не бывает только у тех, кто ничего не делает, поэтому надо честно признать, что ошибки мы допускали, зачастую идя на поводу у уважаемых заказчиков. В большинстве случаев это попытки сэкономить бюджет.

Один из примеров — когда в фреоновой системе охлаждения замерз слив (причем система подогрева имелась), но заказчик, уйдя на зимние каникулы, либо «забыл» его включить, либо решил «сэкономить» на электричестве. Восстановление системы заняло неделю работы в мороз. Пришлось все разбирать и собирать заново…

Вторая типичная ошибка — это проблемы с ДГУ. Мало кто меняет летнюю солярку на зимнюю, при этом забывают долить зимние присадки в топливный бак. А даже если и доливают, то мало кто прогоняет систему, поэтому и замерзают топливопроводы. Такой случай был и в моей практике. Поставили уважаемому заказчику несколько ДГУ в контейнерах. Систему отопления контейнеров предусмотрели, но не сделали отдельного отопления баков и топливопроводов. Продув ДГУ был организован продольно — по оси контейнера, поэтому после запуска ДГУ при -30 °С температура в контейнере упала за 5 минут, а солярка начала замерзать через 15 минут, так как солярка была летней, а дополнительный запас никто не сделал. Спасались ручным управлением воздушными жалюзи. Потом нам с заказчиком пришлось переделывать все контейнеры, утеплять баки и ставить обогрев бака и топливопроводов, а перед зимой во все баки начали добавлять незамерзающие присадки».

Александра Эрлих, генеральный директор CABERO Wärmetauscher Osteuropa GmbH: «Типичная на самом деле ситуация: в Германии из-за неверной эксплуатации «размораживается» от семи до десяти драйкулеров в год (данные по всем немецким производителям. — Прим. ред.). Выручают в этом случае две вещи: при наличии запасов хладагента арендуется временный аппарат, который подключается через садовые шланги до тех пор, пока не будут устранены повреждения в основной системе. Либо (при отсутствии запасов хладагента) используется прямое водяное охлаждение проточной водой».

Александр Овчинников, руководитель проекта ООО «АДМ Партнершип»: «Компания-подрядчик во время проведения пусконаладочных работ при проверке герметичности заполнила систему водой. Согласно плану-графику, данные работы должны были проводиться в августе, но строительство шло с отставанием, и заполнение системы произвели в конце сентября. Системы проверили на давление — собирались уже сливать воду, но ушли на выходные, и как раз в эти дни ударили морозы до -8 °С. В итоге лопнули трубки теплообменников во внешних охладительных градирнях. Их починка уже была невозможна — пришлось менять оборудование. Хорошо, что это произошло еще до момента запуска ЦОДа в эксплуатацию, и последовали затраты только на новое оборудование».

Защита ЦОДа от мороза

Как же защитить дата-центр от подобных случаев? О этом неоднократно рассказывали специалисты со страниц журнала «ЦОДы РФ». Например, подробнее: в выпуске №12 (август 2015 года) приведены реальные примеры работы системы кондиционирования дата-центров, расположенных в регионах нашей страны с резко континентальным климатом. Приведем некоторые из них.

ЦОД «Сибирь», г. Северск: рассчитан суммарно на 1500 серверных стоек в шести машинных залах площадью от 200 до 450 м2. Базовая расчетная электрическая нагрузка составляет 3 кВт на стойку. Максимальная средняя нагрузка на стойку — 9 кВт.

Алексей Волынцев, директор дата-центра «Сибирь»: «В машинных залах теплообмен происходит посредством капиллярных панелей, закрепленных на потолке на высоте 7,1 м и в верхней части стен машзалов. В системе охлаждения использовались компрессоры зарубежного производства и отечественные конденсаторы. Установка усилена фэнкойлами. Система при расходе 1 кВт энергии вырабатывает 4,6 кВт холода. Отобранное тепло через тепловые насосы подается в распределенную отопительную систему здания. А в летнее время (2-3 теплых месяца в году) избытки тепла отводятся за пределы эксплуатируемых помещений. Таким образом отсутствуют затраты на обогрев здания, что позволяет сэкономить около 900 тысяч рублей в год. Несмотря на то что система модульная, во избежание выхода из строя дополнительно предусмотрена система естественного охлаждения: три приточные установки мощностью по 72 000 м3/ч. по схеме резервирования 2N+1».

ЦОД «Мегафон», Новосибирск: общая площадь составляет 2000 м2, количество стоек — 300, мощность объекта — 2,4 МВт.

Александр Салтанов, директор по инфраструктуре Сибирского филиала ПАО «Мегафон»: «В основе климатической системы ЦОДа лежит водяное охлаждение с использованием пяти чиллерных установок: два по 400 кВт и три по 450 кВт. Такой подход потребовал дополнительной модификации пола, который теперь имеет небольшой уклон, чтобы отводить жидкость в случае непредвиденной протечки. Начиная с октября, чиллерные установки переходят на работу с использованием фрикулинга. Систему можно использовать уже при температуре наружного воздуха ниже нуля, однако на стопроцентную мощность чиллерная установка выходит только при внешней температуре -8 °С и ниже. Соответственно, фрикулинг работает только до апреля и позволяет ежемесячно экономить около 400 кВт/ч. Для чиллеров используется схема резервирования N+1, где N — четыре чиллерных установки, еще одна — всегда резервная в системе постоянной ротации. В каждой установке предусмотрены два фреоновых контура, что повышает общую надежность работы системы».

ЦОД «Оптизон», Красноярск: общая мощность машзала составляет 80 кВт, максимальная мощность на стойку — 5 кВт. Дата-центр рассчитан на 15 стоек и строился в основном для нужд операторов связи и операторов доставки контента (CDN). На данный момент ЦОД генерирует 50 % трафика в пиринговую сеть SIBIR-IX.

Дмитрий Гущин, генеральный директор ДЦ «Оптизон»: «В дата-центре установлено 11 сплит-систем DaikinCT60 (девять рабочих и резервные) мощностью по 6 кВт. Схема резервирования — N+2, штатный температурный диапазон составляет примерно -10—15 °С, а низкотемпературный комплект позволяет использовать кондиционер при температуре -40 °С. Зимние комплекты рассчитаны на круглогодичную работу. В пиковые низкотемпературные дни были случаи, когда они не спасали: начиналось обмерзание внутреннего блока теплообменника, и система останавливалась. Благодаря резервированию удалось избежать полной остановки системы. На основе собственного опыта могу сказать, что в дата-центре, серверное помещение которого вмещает до 10 стоек, покупка прецизионных кондиционеров неоправданно: она просто нерентабельна, однако окупается при больших объемах.

Какие дополнительные меры можно принять для защиты зимой?

Во-первых, стоит отметить, что при правильном и грамотном проектировании объекта особенные дополнительные меры не понадобятся. В большинстве случаев в зимнее время года служба эксплуатации ЦОДа пристальнее следит за средствами мониторинга систем и чаще проверяет оборудование. В целом этого достаточно, чтобы быть всегда наготове, если в связи с понижением температур что-то выйдет из строя.

Однако все же есть ряд мер, которые можно иметь в виду. Например, если на объекте установлена система фрикулинга, то в первую очередь необходимо проверить и закрыть внешние подходы к кондиционерам — для этих решений морозы намного опаснее жары. При отрицательных температурах — главное, чтобы не застыл хладагент в трубах, вследствие чего он перестанет циркулировать. Как утверждают эксперты, к сожалению, служба эксплуатации ЦОДа зачастую просто увеличивает концентрацию хладагента, что может лишь усугубить проблему. В этом случае прежде всего спасет добавление антифриза. Помимо этого, трубы оснащены системой отопления, которую необходимо постоянно проверять, когда температура опускается ниже нуля и тем более экстремально ниже нуля.

Одно дело, кондиционеры и трубы, другое — сам машинный зал. Все мы знаем, что холодный воздух намного суше, поэтому в зимнее время года и особенно при резком понижении температуры за окном необходимо проверять уровень влажности — он может значительно снизиться. Для его увеличения до оптимального показателя советуют использовать портативные увлажнители.

Защита дата-центра в минусовые температуры зависит не только от контроля системы охлаждения: нельзя забывать и о ДГУ, которые стоят на улице. Как и любой аккумулятор, аккумулятор дизель-генератора при холодных температурах теряет свою емкость, то есть при морозе от -30 °С он не сможет резко отдать ту энергию, какую мог бы отдать, будучи теплым. Чтобы в случае экстренных ситуаций не потерять время на подключение ДГУ, эксперты советуют устраивать своего рода «тренировки» дизелю, включая его на 20-процентную нагрузку на 10-15 сек. После этого можно запускать генератор на непродолжительное время стартером. К сожалению, не все современные ДГУ дают возможность проводить подобные «учения», поэтому инженерам дата-центра приходится искать и другие способы прогревания аккумуляторов, например, устанавливать подзаряжающие устройства. В любом случае одна из главных задач в данном случае — следить за уровнем электролита: если его плотность сильно падает, то вода превратится в лед, а банка аккумулятора раздуется и может треснуть.

Так или иначе, контроль систем охлаждения зависит от слаженности работы службы эксплуатации дата-центра: это не только своевременные проверки оборудования, но и связи между инженерами на случай экстренных ситуаций. Будем надеяться, что такие морозы уже больше не вернутся в Москву, а если и вернутся, то дата-центры будут готовы их встретить.

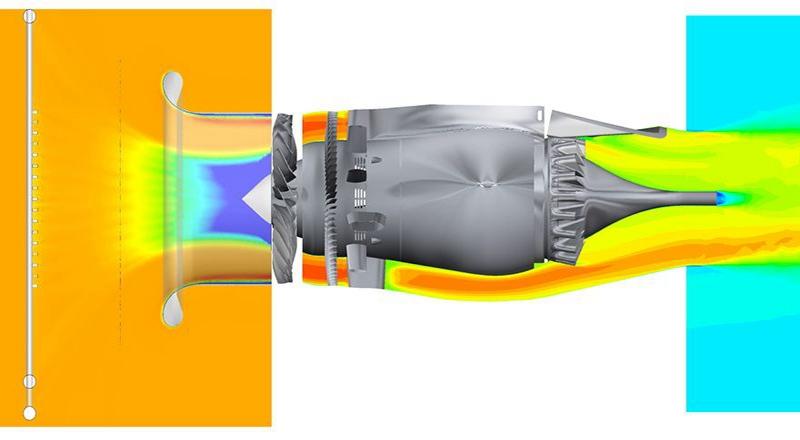

Каждый центр обработки данных (ЦОД), независимо от его размера, сталкивается с одной и той же проблемой: электроэнергия, необходимая для работы серверов, систем хранения данных и сетевых компонентов, превращается в тепловую энергию, которую нужно отводить. Поэтому ключевое значение для эффективного функционирования ЦОДов приобретают системы контроля микроклимата. Чтобы изыскать возможности повышения эффективности дата-центра, стоит использовать оптимизированную концепцию контроля микроклимата.

В общем случае так называемую цепь охлаждения в центре обработки данных можно разделить на три области: производство, передача и распределение холода. В большинстве случаев используется водоохладительная система, сочетающая открытый или сухой охладитель с одним или несколькими чиллерами. Согласно этой концепции холод передается в дата-центр с помощью охлажденной воды, а выделяемое тепло отводится в обратном направлении с нагретой водой. Вода охлаждается при этом с помощью теплообменника агрегата естественного охлаждения, в который теплообменник вдувает холодный наружный воздух. После этого система с помощью насосов подает охлажденную воду обратно в дата-центр. Степень нагрузки на агрегат естественного охлаждения зависит от двух важных факторов — температуры подаваемой воды и температуры наружного воздуха.

Температура подаваемой воды и наружного воздуха

Говоря о температуре подаваемой воды, имеют в виду воду, идущую через теплообменник в ЦОД, где она обеспечивает подведение холодного воздуха на серверы. При этом серверы согласно стандарту ASHRAE могут работать без проблем при температуре поступающего воздуха до +27 °C. Значение температуры подаваемой воды зависит от температурных потерь при передаче холода и эффективности его распределения. Поскольку в европейских широтах большую часть года возможно естественное охлаждение с использованием наружного воздуха, потребитель одновременно экономит и деньги. Однако возможен и комбинированный режим, при котором вода сначала предварительно охлаждается с помощью агрегата естественного охлаждения, а затем доводится до желаемой температуры с помощью чиллера. Лишь в очень жаркие летние дни, когда наружная температура выше, чем у отводимой воды, прибегают к режиму охлаждения только с помощью чиллеров.

Альтернативный способ получения холода могут обеспечивать, например, геотермальные источники и морская вода. Холодную наружную воду можно получать, перекачивая грунтовые воды. Поскольку в этой системе два водяных контура полностью отделены друг от друга и сопряжены только через теплообменник, речь идет о «непрямом естественном охлаждении». При «прямом естественном охлаждении» средством переноса служит холодный воздух. В этом случае не нужны теплообменники, насосы и трубопроводы, что повышает эффективность еще больше.

Высокоэффективные, надежные и устойчивые: восемь климатических систем обеспечивают охлаждение в вычислительном центре компании IGN GmbH.

Учет параметров окружающей среды

При температуре подводимого к серверам воздуха до +27 °C холодный наружный воздух можно использовать большую часть года, не прибегая к дополнительным мерам для его охлаждения. Однако при прямом естественном охлаждении нужно учитывать следующие граничные условия.

Поступающий в ЦОД воздух не должен быть слишком холодным, так как иначе он может привести к образованию конденсата. Поэтому подаваемый воздух смешивается с теплым отходящим — для достижения оптимальной температуры подводимого к серверам. Следует также учитывать влажность воздуха (конденсат, статический заряд) и при необходимости использовать увлажнители и осушители. Кроме того, необходимо применять фильтры против пыли и — в зависимости от условий — против вредных газов. На случай, если наружная температура стала выше, чем у подаваемого воздуха, следует предусмотреть дополнительные меры по охлаждению. Это могут быть охладители, добавляющие холодный воздух, или новейшие технологии, такие как адиабатическое охлаждение, при котором создается тонкораспыленный водяной туман. В последнем случае охлаждение при испарении обеспечивает достижение нужной температуры, при этом также повышается влажность воздуха. Интересный вариант прямого естественного охлаждения представляют собой вращающиеся теплообменники, применяемые уже много десятилетий для выработки тепла в системах кондиционирования воздуха в зданиях.

Прямое естественное охлаждение позволяет достичь исключительных показателей эффективности, что подтверждается многочисленными примерами реализации подобных решений у клиентов.

Решающая роль управления воздушными потоками

Важным пунктом при создании целостной концепции контроля микроклимата в центрах обработки данных является эффективное распределение холода в серверных помещениях. Решающее значение при этом имеет средняя тепловая нагрузка серверного шкафа. Если тепловая нагрузка ниже 6–7 кВт на один шкаф, то холодный воздух можно подводить к серверам по фальшполу с помощью систем CRAC (Computer Room Air Conditioning). Они забирают теплый воздух из серверного помещения, охлаждают его с помощью теплообменника и подают под фальшпол. Перфорированные панели фальшпола перед серверными шкафами обеспечивают целенаправленную подачу воздуха.

Рекомендуется использовать систему отделения коридоров, с помощью которой зоны холодного и теплого воздуха изолируются друг от друга, что предотвращает смешивание и экономит энергию. Для этого шкаф герметизируется, чтобы не было циркуляции воздуха между передней и задней стенками, а холодный воздух проходил исключительно через серверы. Ряды шкафов располагают так, чтобы шкафы были обращены друг к другу либо передними стенками, либо задними, образуя холодные и теплые зоны. Сверху и в местах доступа проходы закрываются перегородками.

Повышение тепловыделения — повышение сложности

Когда в подобной системе охлаждения помещения имеется кластер большой плотности со значительно более высоким уровнем тепловых потерь мощности в шкафу, обеспечить подведение достаточного количества холодного воздуха через фальшпол уже невозможно. Такая горячая зона должна быть оснащена системой охлаждения шкафа. Если средние потери мощности в шкафах увеличиваются, становится все труднее подавать на них холодный воздух через фальшпол.

Альтернативой этому способу является охлаждение рядов стоек. В этом случае теплообменники устанавливаются в одном ряду с серверными шкафами и образуют систему холодных и горячих коридоров. Фальшпол для подведения воздуха при этом не требуется, так как внутрирядные устройства контроля микроклимата подают холодный воздух непосредственно в холодный коридор, из которого он втягивается серверами. Отработанный воздух, выходящий из серверов в горячий коридор, снова попадает в устройства контроля микроклимата и охлаждается с помощью теплообменников. Поскольку теперь путь движения воздуха между устройством контроля микроклимата и серверами стал короче, возможно перемещение большего объема воздуха — а следовательно, отвод большего количества выделяемого тепла.

Контроль микроклимата в шкафу

В случае высоких тепловых потерь мощности рекомендуется использовать третий вариант — системы контроля микроклимата в шкафу. Теплообменник монтируется на шкаф сбоку и подает холодный воздух непосредственно в пространство перед сервером. Теплый воздух отводится из самого шкафа и подается в теплообменник. Таким образом, воздух циркулирует в горизонтальном направлении в ограниченном пространстве, включающем серверный шкаф и устройство контроля микроклимата в шкафу.

Особый вариант этого решения представляет собой задняя дверь с пассивным теплообменником (RDHx). Теплый воздух вытесняется из серверов через этот теплообменник с помощью встроенных в серверы вентиляторов. Теплообменник охлаждает отводимый воздух и выпускает его в окружающее пространство, откуда он может снова поступать в серверы.

В итоге: чтобы разработать оптимальную концепцию контроля микроклимата в дата-центре, необходимо организовать производство, передачу и распределение холода в точном соответствии с требованиями серверов. Правильный выбор параметров и оптимальная рабочая точка системы контроля микроклимата — это залог энергоэффективности дата-центра.

Человеческий фактор

Практика показывает, что некорректная эксплуатация инженерного оборудования и пресловутый человеческий фактор остаются одними из наиболее распространенных причин аварий в ЦОДах:

- Плохо выполненная работа по обслуживанию системы ИБП коммерческого центра обработки данных в австралийском Сиднее, штат Новый Южный Уэльс, привела к перебоям в его работе. Авария произошла в одном из местных ЦОД компании Vocus Communications.

Она случалась 13 февраля 2018 года в ранние часы утра. Из-за инцидента один из крупных клиентов этого колокейшн-провайдера в лице компании Servers Australia принял решение о перемещении всего своего оборудования из данной северной фермы в другую в течение следующих трех месяцев.

Авария произошла в ЦОД, который находится в сиднейском пригороде Александрия. Перебои в работе силовой инфраструктуры этого дата-центра начались примерно в 7 утра по местному времени (AEST). Устранить неполадки удалось в тот же день.

- Похожий инцидент произошел 25 января 2018 года в Соединенном Королевстве Великобритании и Северной Ирландии. Из-за технических проблем в работе инфраструктуры дата-центров компании NHS Wales врачи общей практики по всему Уэльсу оказались лишены возможности получать доступ к документам о пациентах.

Неполадки были зафиксированы в работе двух ЦОД. Оба дата-центра, используемые системой здравоохранения страны, были недоступны в течение 2 часов. Эти ЦОД располагаются в Блаенавоне и Кардиффе. Примерно в 3 часа дня по местному времени (GMT) команда NHS Wales сообщила, что «технические проблемы» затрагивают два объекта, пообещав скорейшее их устранение, назвав эту задачу «приоритетной». Доступ к сервисам вновь появился через два часа после аварии.

Облако Amazon ушло в офлайн

В конце февраля 2017 года человеческий фактор стал причиной того, что была отключена часть серверов публичного облачного сервиса Amazon Web Services. Данный инцидент показал, что для вывода из строя даже такой надежной облачной платформы, как AWS, достаточно всего лишь одного неверного действия. 28 февраля уполномоченный член группы технической эксплуатации одного из дата-центров, поддерживающих работоспособность платформы Amazon Web Services, допустил ошибку во время набора текста команды, что привело к серьезному сбою. В результате инцидента начались перебои в работе многих популярных сайтов Trello, Coursera, IFTTT, а также ресурсов крупных партнеров Amazon из списка S&P 500. Ущерб составил сотни миллионов долларов США.

Как показало внутреннее расследование, ошибка была допущена при вводе команды во время отладки процесса выставления счетов клиентам облачного хранилища Amazon Simple Storage Service (AWS S3). Инженер использовал стандартный инструментарий для выполнения команды на удаление небольшого количества серверов в одной из подсистем AWS S3, необходимой для биллинга. Во время подготовки команды один из блоков данных был введен неправильно. В итоге удалился более крупный кластер серверов, чем предполагалось изначально.

Непреднамеренно удаленные сотрудником серверы использовались для поддержания работоспособности двух других важнейших программных модулей AWS S3. Первым была индексная подсистема, управляющая сведениями о метаданных и расположении всех объектов AWS S3 в регионе US-EAST-1 (используется американскими клиентами). Она также применяется при обработке запросов к облаку. Вторая затронутая инцидентом подсистема применяется при размещении данных и управлении распределением места в облачном хранилище. Из-за удаления серверов возникла необходимость полного перезапуска этих двух подсистем, после чего хранилище AWS S3 оказалось не в состоянии обслуживать запросы клиентов в течение длительного времени. Это привело к нарушению работоспособности ряда других облачных сервисов Amazon, использующих ресурсы AWS S3.

Пожаротушение и человеческий фактор

В первый месяц осени, 29 сентября, серьезный сбой произошел и в одном из ЦОДов популярного облачного сервиса Microsoft Azure. Жертвой человеческого фактора в данном случае оказалось не программное, а аппаратное обеспечение. Если точнее, инженерная инфраструктура ЦОДа. Ошибка проектировщиков и/или строителей дата-центра в Северной Европе привела к неожиданному срабатыванию автоматизированной системы газового пожаротушения и выпуску инертного газа в машинный зал. Инцидент произошел в ходе проведения плановых работ по техобслуживанию подсистем дата-центра. Он привел к перебоям в течение семи часов в работе облачной платформы Microsoft Azure, которые нанесли серьезный ущерб бизнесу ряда клиентов американского софтверного гиганта.

Официальное расследование показало, что после попадания инертного газа в машзал ЦОДа автоматически остановились многочисленные установки подготовки воздуха внутри здания. После этого начала расти температура воздуха в изолированных зонах серверных, что, в свою очередь, привело к автоматическому отключению некоторых вычислительных систем, сетевого оборудования и СХД. Помимо этого, часть ИТ-оборудования начала циклически перезагружаться.

К счастью, операторы ЦОДа быстро заметили аварию и оперативно отреагировали на случившееся. Уже через 35 минут им удалось восстановить работоспособность всех холодильных агрегатов и вернуть температуру воздуха в машзале к нормальному уровню. Но специалистам не удалось избежать потери некоторых серверов и систем хранения данных. Как следствие, им понадобилось дополнительное время для устранения неполадок в работе ИТ-оборудования. Из-за этого сбоя некоторые европейские клиенты Azure столкнулись с проблемами при подключении к облаку и управлении ресурсами, размещенными на базе этой платформы.

Еще один похожий инцидент случился в конце сентября. Но в этом случае местом действия стал один из лондонских колледжей. Сбой случился в ходе проведения тестов оборудования ЦОДа. Специалисты проверяли качество воздуха в помещении для оценки на соответствие стандарту ISO14644-1 (класс 8), предполагающему, что количество частиц размером 0,5 микрона в воздухе должно быть ниже 3,52 млн на 1 кубометр.

В ходе одного из экспериментов в серверной комнате возникло возгорание. После начала пожара установленная в серверной система пожаротушения выпустила инертный газ, при этом ИТ-оборудование было включено и работало. Но самое неприятное — в результате срабатывания сама система АГПТ начала разрушаться, и на оборудование в серверной начали сыпаться ее обломки. Ситуацию усугубил тот факт, что один из сотрудников учреждения образования, находившийся в комнате во время пожара, использовал стандартный огнетушитель для ликвидации возгорания. В конечном итоге часть серверов колледжа получила серьезные повреждения, тогда как остальные машины ушли на длительное время в офлайн. Команде инженеров, прибывших на место происшествия через два часа после начала пожара, пришлось трудиться всю ночь, чтобы восстановить работоспособность ИТ-систем.

К счастью, инженерам удалось привести вычислительную инфраструктуру вуза в рабочее состояние — студенты и преподаватели смогли использовать ее уже на следующий день. Тем не менее администрации лондонского колледжа впоследствии пришлось обратиться за помощью к специалистам по сбору электронного мусора, которые утилизировали выведенные из строя серверы.

Как показывает практика, системы газового пожаротушения в большинстве своем способны вызывать резкое снижение температуры воздуха в помещении, а также влиять на давление воздуха, приводя к возникновению шума во время своей эксплуатации и ударной волны при отключении. Кроме того, выделяемый этими системами газ может выступать своеобразным «абразивом», повреждающим чувствительное оборудование.

Цена спешки

Ошибки во время проектирования и строительства ЦОДа — весьма распространенное явление, которое может иметь далеко идущие негативные последствия. Данный факт могут подтвердить операторы дата-центров европейского провайдера облачных сервисов OVH, который активно отвоевывает рынок Старого Света у Microsoft Azure и Amazon Web Services. Из-за масштабного сбоя, произошедшего 9 ноября в одном из кампусов компании, руководство OVH объявило о закрытии и демонтаже двух из трех находящихся там дата-центров. Речь идет о комплексе ЦОДов в Страсбурге (Франция). Часть находящихся на его территории машинных залов была создана на основе контейнерных ЦОДов, которые устанавливали второпях — всего за два месяца. Чтобы сэкономить время, оператор пренебрег стандартной практикой и не обеспечил наличие двух избыточных силовых линий от независимых электрических сетей, ограничившись одним подключением на 20 кВ. Как часто бывает в таких ситуациях, авария основной электросети не заставила себя долго ждать. Следствием этого стало отключение части оборудования ЦОДов и длительное нарушение в работе клиентских приложений. Неудивительно, что после инцидента, который нанес серьезный урон репутации OVH, было принято решение о переоборудовании кампуса.

Чтобы минимизировать вероятность подобных инцидентов, компания Fulcrum Collaborations разработала облачный инструментарий для автоматизации и стандартизации ручных процессов в ЦОД, позволяющий устранить ошибки операторов-людей при повседневном управлении и обслуживании критически важной инфраструктуры.

Созданная компанией Fulcrum Collaborations программная платформа MCIM относится к категории программного обеспечения для компьютеризированного обслуживания и управления (Computerized Maintenance and Management Software; CMMS). Платформа MCIM доступна на мобильных устройствах и может обеспечивать автоматизацию самых разных задач: от группирования информации до генерации отчетов с интеллектуальным выявлением трендов.